こんにちは!

Exploratoryの西田です。

先週お伝えしたアメリカの選挙結果をどの世論調査よりも高い精度で予測した賭けサイトのPolymarketの創業者/CEO、Shayne Coplan氏が、先週FBIによる家宅捜査をうけました。(リンク)理由は、賭けに参加していたユーザーにアメリカ人が含まれている可能性があるからということです。

以前にこちらのビデオでも解説しましたが、実はアメリカではアメリカ人のオンラインでの賭けは禁止されていたため、アメリカ人はVPNを使って外国からのユーザーであるふりをして賭けに参加していると言われていました。

しかし、今年の春にはオンラインでの賭けに対する規制が緩くなり、例えばRobinhoodなどのスタートアップは実際に今回の大統領選挙の賭けをアメリカ市民を対象に堂々と行っていました。

また、Polymarketは2020年に創業し、2020年の大統領選挙、2022年の中間選挙でも同じような賭けを提供してきていただけに、このタイミングでの家宅捜査は、今回の選挙で負けることになった現民主党政権による影響が疑われています。(FBIは司法省管轄で、FBI長官も司法長官も現民主党人事です。)

選挙中に選挙に関する世論調査を行いそれをメディアが全国的に報道すると、その調査結果自体が選挙に影響を与えると言われています。例えば選挙日に近いタイミングで、ある民主党候補が圧倒的に勝つ可能性が高いだろうという報道が多くなれば、共和党候補を支持する人たちはあきらめて投票に行かなくなるといった具合にです。

そのため、選挙結果の予測を取り締まりたいというモチベーションはどちらの党にもあるわけです。賭けサイトによる大統領選挙の予測に関しては、選挙の前にこちらのビデオで解説していますので、まだ見てない人はぜひご覧ください。

ところで、今回の選挙では共和党が大統領、上院多数派、下院多数派の全てを全てを取ることになり、レッドウェーブ(赤い波)が起きたと言われています。(アメリカでは共和党が赤で、民主党が青ということになっています。)

その原因は、この4年間の民主党バイデン政権の間に一般庶民にとっての経済状況がかなり悪くなり、さらに州や市レベルを含めた民主党政府の違法移民や犯罪者に対する甘い対応による治安の悪化、シリコンバレーのテック企業などを狙い撃ちにした規制、訴訟、検閲などの多くがあげられます。

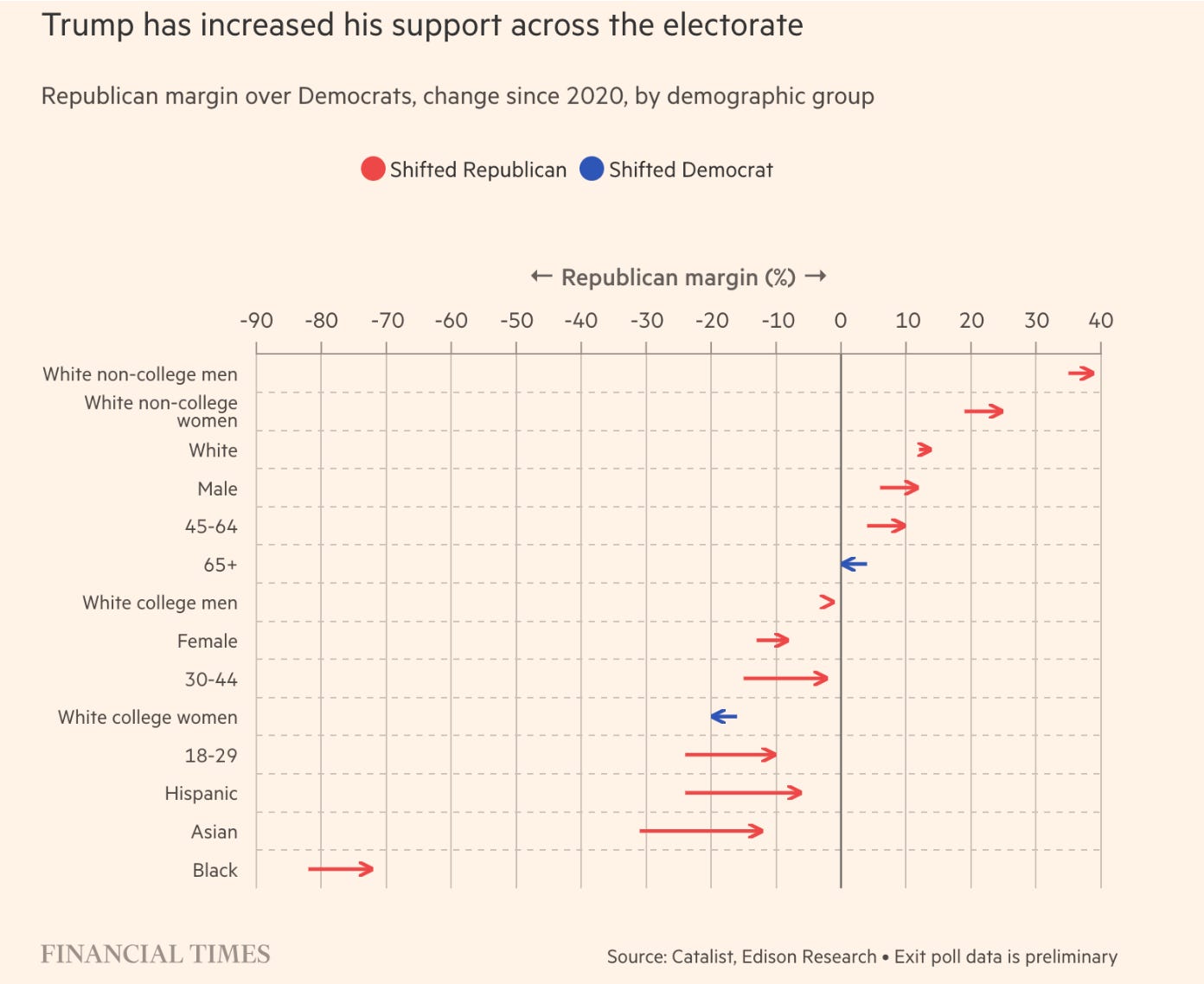

こうした理由もあって、今回の選挙では様々な層において民主党支持から共和党支持への乗り換えというトレンドが見られました。

その中でも、歴史的に民主党支持が圧倒的に多かったヒスパニック系(中南米系)アメリカ人の多くが共和党支持に乗り換えた、というのが今回の大きなレッドウェーブの原動力だったと言われています。

この点に関して以下のビデオで詳しく解説していますので、ぜひご覧ください!

ちなみに、上記のチャートの中で民主党支持が増えた層が2つあります。1つは白人の大卒女性ですが、これは中絶が1つの争点だったためです。(共和党は州レベルに任せたい、民主党は連邦政府レベルで推進したい)

もう1つは65歳以上というグループですが、これはテレビの影響だ思われます。

アメリカのテレビや新聞は歴史的にほとんどがリベラル系、民主党寄りですが、特にここ最近はその傾向が極端になってきていて、まるでそれは民主党専属報道機関であるかのごとくです。

そして、こうしたテレビや新聞のニュースから情報を得ている割合が最も高いのがこの65歳以上というグループなのです。(リンク)

TVや新聞などの伝統的なメディアがあまりにも左に寄りすぎた結果、そうしたメディアに対する信用はこの20年ほどの間に特に共和党寄り、そして独立派の人たちの間で相当低くなりました。(リンク)

こうした伝統的なメディアの影響力の低下も今回の選挙結果に大きな影響を与えることになったのではないかと思います。

ちなみに、ポッドキャストやX、Youtubeなどが特に若年層への影響力を増大させているメディアとして挙げられていますが(リンク)。

データ、AI関連ニュース

機械学習を用いた科学における再現性の危機

最近はよく機械学習を利用した科学研究におけるブレイクスルー的な発見のニュースがよく出てきます。しかし、実はそうしたものの中には、データリーケージ(データ漏洩)というタイプのエラーに基づいているものが少なくないとする「機械学習を用いた科学におけるリーケージと再現性の危機」という論文が最近発表されました。

Leakage and the reproducibility crisis in machine-learning-based science - Link

データリーケージとは、意図せずモデルの予測に影響を与える情報がデータの中に混入してしまう現象であり、このために結果が偏ってしまい、科学分野全体で再現性の危機を引き起こしている可能性があると語られています。

論文によると、このデータリーケージの問題は思った以上に多くの研究で発生しており、特に医療や環境科学などの分野でよく見られるとのことで、こうした問題によりモデルの性能に関して過度な主張につながっている可能性を指摘しています。

対策として検証方法の改善と、データ処理に関する意識向上の必要性を強調していますが、これはデータ分析を長年やってきた人たちからすると、お馴染みの問題のように聞こえるかもしれません。

機械学習やAIの性能がどんどん進化しているのは事実ですが、だからといって手放しで新しい科学的発見につながるとは言えないということですね。

これはビジネスにおける機械学習やAIモデルの活用においても同じことが言えると多いますので、気をつけたいところです。

深層学習はすでに天井が見えているのか

スケーリング仮説というのを知っていますか?

このニュースレターでも過去に話したことがありますが、現在のLLMのようなAIモデルはデータ量、トレーニングにかける時間、パラメーターの数を増やせば増やすほど、その性能はどんどんと進化していくというものです。

この仮説を元に、ファウンデーションモデル(大量のデータを用いてトレーニングしたLLMのようなAIモデル)の性能を改善させるために、OpenAI、Anthoropic、Google、Meta、MicrosoftといったAI企業は大量のGPUを買い集め、大規模なデータセンターを用意し、莫大な電力の確保に必死です。最近世界中で原子力発電所建設ブームが起きているのもこれが原因です。

しかし最近、前述のスケーリング仮説を提唱したIlya Sutskever氏(OpenAIの創業メンバー、現在はSSI(Safe Superintelligence)というAI研究所を創業)がこのスケーリングが天井に達したということを言っていました。(リンク)

このことについて、非常に面白い分析記事があったので、こちらで解説します。

Is Deep Learning Actually Hitting a Wall? - Link

AIの性能が頭打ちしていると言われる理由の1つとして挙げられているのは、モデルのトレーニング(事前学習)用に使われてきたクオリティの高いデータ、つまり人によって作り出されてきたデータ(本やブログ記事など)やこれまでのシステムによって作られてきたデータはもうほとんどすでに使い果たしてしまったからだというものです。

そうなると、AIによってデータを人工的に生成しない限りデータは増えないということですが、逆にこうしたデータを使うことでモデルのクオリティが落ちることになってしまうことも確認されていると言われています。

実際、OpenAIはGPT-3からGPT-4の時に見せたような進化を次期バージョンでもたらすことに苦労しているとのことで、Orionと呼ばれる現在開発中のバージョンはGPT-5とは呼ばれないかもしれないとのことです。Claudeの開発元であるAnthoropicも同じような問題に直面しているとのことです。

こちらのチャートはOpenAIがo1モデルを発表したときに出したものですが、横軸が左側のチャートはトレーニング時間、右側はテスト時間、縦軸はどちらもモデルの予測精度となっています。

これを見るとトレーニングに時間をかければかけるほど、つまりデータの量を増やしてパラメーターの数を増やすと予測精度が上がるように見えます。

しかしここで注意したいのは、横軸はログスケール(例えば1目盛10倍ずつで増えていく)なのに対して、縦軸はそのままのスケールです。ということは、モデルのトレーニングにかかる時間が指数関数的に増えていくのに対して、精度は線形関数的(段階的)にしか上がらないということで、莫大なコストをかければかけるほどリターンは限定的になっていくということを示しています。

現在ではこうしたモデルの性能改善はトレーニングフェーズではなく、推論フェーズにウェイトが移っています。例えばChatGPTであれば、o1モデルがそうですね。

しかし、この推論型というのはユーザーからのリクエストに対して演算処理に時間をかけることで解答のクオリティを上げようとするものですが、そのことがビジネス的には問題になるのではないかと著者は言います。

それは、ユニット・エコノミクス(収益性)の問題です。

LLMなどファウンデーションモデルを元にしたAIビジネスのユニット・エコノミクス(収益性)はソフトウェアビジネスに比べるとあまりよくありません。というのもソフトウェアビジネスであれば一度プロダクトを作ってしまえば、その後に規模を拡大するためにかかる費用はほぼゼロです。車であれば作る度にコストがかかりますが、ソフトウェアを複製するコストはゼロです。そして複製にかかる時間もほぼゼロです。

しかし、現在のようなAIは、特にChatGPTであればo1といった推論型のAIは演算部分に時間をかけることで性能が良くなるため、ユーザーにサービスを提供すればするほどコストがかかります。例えばChatGPTのo1-preview(推論型モデル)はGPT-4oの6倍ほどの価格です。(リンク)

もし、現在のようにトレーニングによってモデルの性能を上げることに限界が来ているため、o1のような推論型(演算処理に時間をかける)に希望があるというのであれば、それはさらなるコストの増加を意味します。

ファウンデーションモデルを作るAI企業間の競争は熾烈を極め、現在ではどこの会社のモデルも性能的には大差ありません。これはある意味、自動車産業と変わりません。つまり大規模なデータセンター(製造工場)を作り、大量のユーザーに提供することで低コストにするという「規模の経済」型ビジネスです。

そのため、もしAIの性能を上げるためのコストが指数関数的に上がっていくのに比べてそのリターンである性能の改善が線形でしか上がっていかないのであれば、OpenAIなどファウンデーションモデルを提供するAI企業のビジネスモデルは期待されているほどのリターン(収益)を上げないのではないかと著者は疑問を投げかけます。

もちろん、プライベートセクターであればビジネスモデルが問題になりますが、政府であれば別です。例えば、アメリカの防衛省にとってはAIの性能を進化させることは国家安全保障にとって重要ですから、利益関係なしに莫大なコストをかけてAIをさらに進化させるための投資と研究を続けることができます。

ただ、70年代にアメリカ政府が人間を月に送ったのをピークにアメリカの宇宙探索における進化は止まってしまったように(最近では民間企業のSpaceXによってようやく技術革新が見られようになりましたが)、政府は技術を進化させ続けることが苦手だということも忘れてはいけません。

AGI(Artificial General Intelligence / 汎用人工知能)を含めたAIの進化に関する予測を難しくするのは、最新のAI技術に関する情報を持っている人たちは、たいてい何らかの金銭的な動機を持っています。OpenAI、Googleなどの重役であったり、新しいAIスタートアップの創業チームであったりという具合です。

そして彼らは投資家からの莫大な資金を必要としています。というのも、AIモデルを現在の仕組みの中で進化させるためには、それが莫大な利益をもたらすかどうかは抜きにして、莫大な費用(データセンター、電力、GPUなど)を必要とするためです。

そこで、こうしたAIを開発している人たちは、数年以内にAGI(Artificial General Intelligence / 汎用人工知能)が可能だといった大きな風呂敷を広げなくてはいけないという面もあります。

しかし、たとえそれが可能であったとしても、それを作り出すにはあまりにもコストがかかり過ぎるため、結局はAGIによって人間の仕事を完全に置き換えるというのは、まだまだかなり先の話なのかもしれません。

データサイエンス・ブートキャンプ・トレーニング #37

おかげさまでいつもご好評いただいおりますデータサイエンス・ブートキャンプですが、現在12月版への参加申し込みを開始しております。

ビジネスのデータ分析だけでなく、日常生活やキャリア構築にも役立つデータリテラシー、そして「よりよい意思決定」をしていくために必要になるデータをもとにした「科学的思考」もいっしょに習得していただけるトレーニングとなっています。

データサイエンス、統計の手法、データ分析を1から体系的に学ぶことで、ビジネスの現場で使える実践的なスキルを身につけたいという方は、ぜひこの機会に参加をご検討ください!

日時:2024年12月17日(火), 18日(水), 19日(木)

場所:東京八重洲(対面形式)

今回のニュースレターは以上となります。

それでは、素晴らしい残りの週末をお送りください!

西田, Exploratory/CEO

KanAugust